上传测试文件HDFS目录

本地运行pyspark程序 进入pysaprk

查看当前运行模式

读取本地文件并显示项数

读取HDFS文件

在Hadoop YARN运行pysaprk 修改yarn文件yarn-site.xml

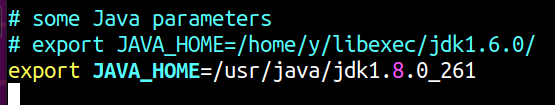

修改yarn-env.sh sudo gedit /usr/local/hadoop/etc/hadoop/yarn-env.sh

声明,由于版本问题,我把java1.8皇城java1了,其他配置不变

HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop pyspark --master yarn --deploy-mode client

查看当前运行模式

读取本地文件并显示项数

读取HDFS文件

Spark伪分布版安装 添加spark到系统环境变量

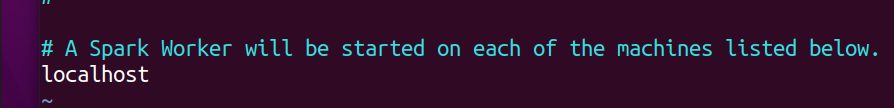

配置slaves

spark-shell

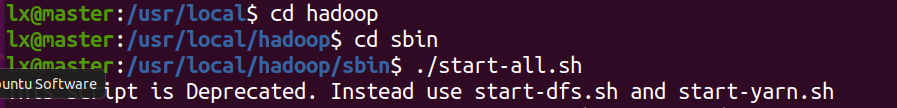

进入Hadoop的sbin目录执行./start-all.sh启动 使用jps看下进程信息 进入spark的sbin目录下执行./start-all.sh启动spark, 启动后,jps查看最新进程

http://localhost:8080,进入spark的web控制台页面

使用命令./bin/spark-shell启动SparkContex

通过访问http://localhost:4040进入spark-shell web控制台页面

关闭Spark

关闭Hadoop

重命名 为避免与Hadoop的命令冲突: 进入/usr/local/spark/sbin start-all.sh文件改名为: start-all-spark.sh stop-all.sh文件改名为: stop-all-spark.sh

在Spark Stand alone运行pyspark 启动hadoop

启动Spark Stand alone

在Spark Standalone运行pyspark pyspark --master spark://master:7077

http://localhost:8080/

查看当前运行模式

读取本地文件并显示项数

读取HDFS文件